本文介绍如何在 Mac(特别是 M 系列芯片)上安装和使用 Ollama,以便在本地流畅运行 Gemma、Llama 3 等大型语言模型。

1. 安装 Ollama

访问 Ollama 官网下载 macOS 版本进行安装:

https://ollama.com/

2. 常用命令速查

2.1 服务管理

1 | # 启动 Ollama 服务 (一般安装后会自动启动) |

2.2 模型运行与管理

1 | # 运行模型 (如果模型不存在会自动下载) |

2.3 其他操作

1 | # 查看模型详细信息 |

3. 实战示例

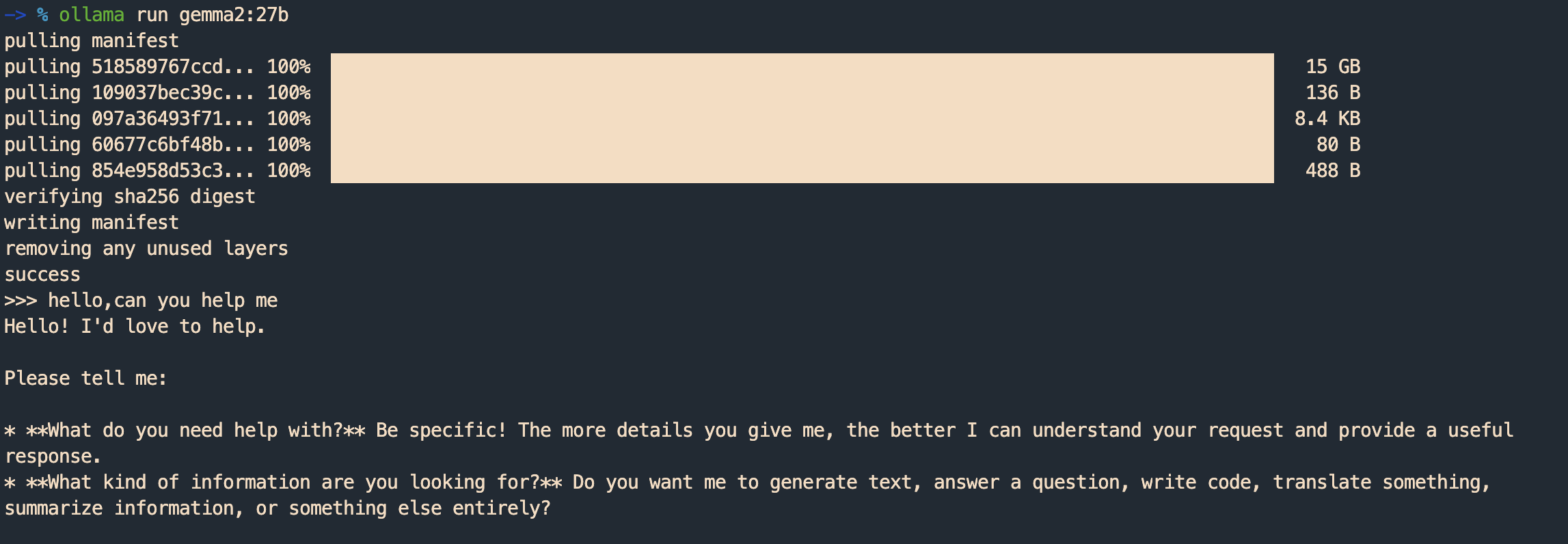

运行 Gemma 2 (27B)

1 | ollama run gemma2:27b |

运行后,你将进入一个交互式的聊天界面,可以直接输入问题与模型进行对话。

本文作者: NUK

最后更新: 2026年01月08日 17:59:45

本文链接: http://www.uilucky.com/post/6399e4ff.html

版权声明: 本作品采用 CC BY-NC-SA 4.0 许可协议进行许可,转载请注明出处!